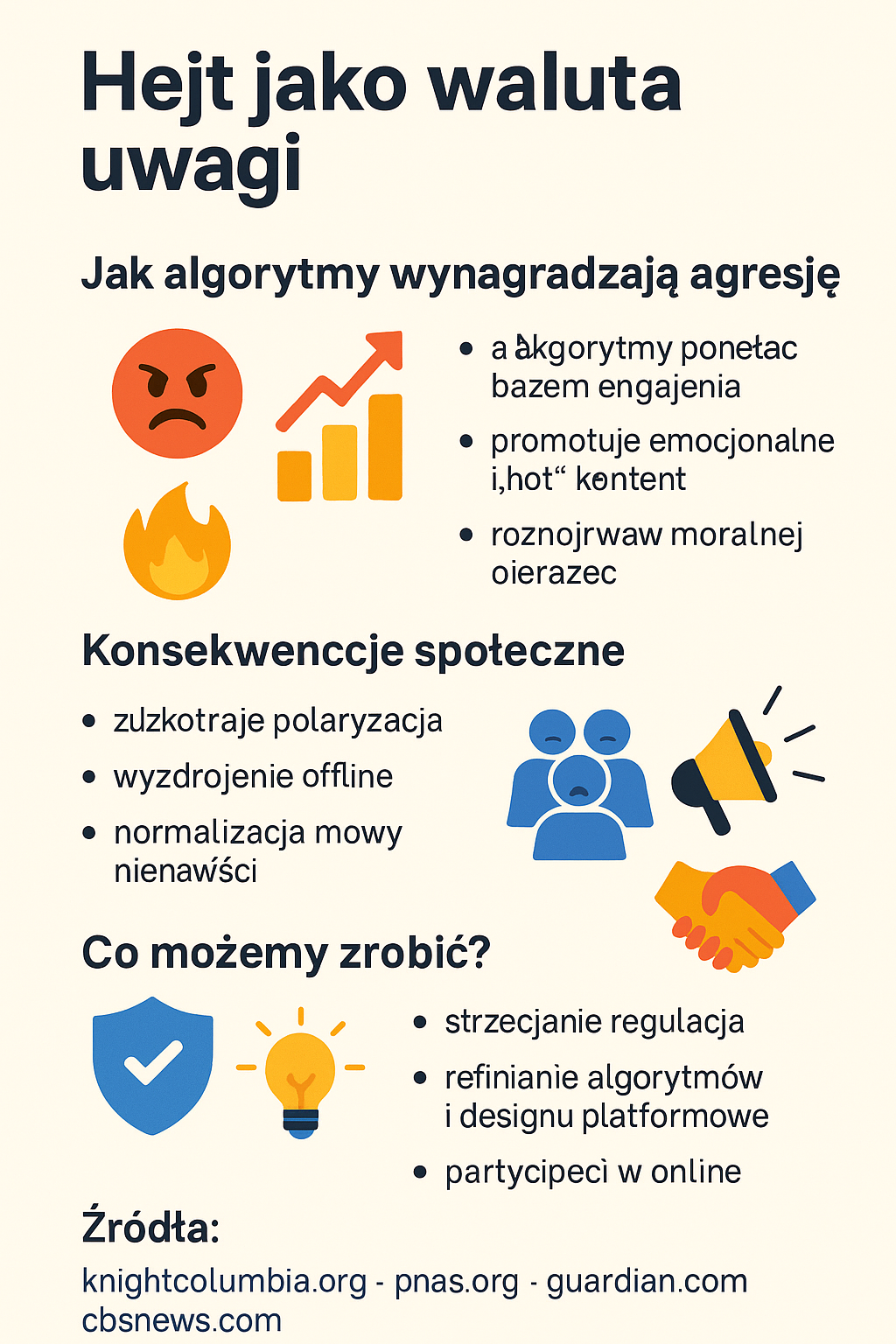

Jak algorytmy wynagradzają agresję i co możemy z tym zrobić

Algorytmy Big Techu od lat odkryły, że gniew klika się jak kotki, tylko pięć razy lepiej—dlatego Twitter podsuwa wpisy z wściekłością o 62 % częściej, Facebook pompuje 😡 pięciokrotnie mocniej niż 👍, a YouTube po kilku klikach prowadzi wprost do ekstremistycznej nory. W rezultacie dostajemy politykę w trybie kapsaicyny: rozgrzewa, uzależnia i wypala zaufanie społeczne, serwując przy okazji realną przemoc offline i młodzież żyjącą na stałym wyrzucie kortyzolu. Bruksela straszy Digital Services Actem, Waszyngton macha Algorithmic Accountability Actem, a platformy udają skruchę, dorzucając „feed chronologiczny” i okienko „czy na pewno”, jakby plasterek mógł zatamować krwotok. Póki model biznesowy nagradza burzę, nie pogodę, gniew pozostanie najcenniejszą walutą sieci—i tylko od nas zależy, czy będziemy w nim płacić, czy przestaniemy dokarmiać algorytmicznego potwora. Oto kilka faktów i może punktów wartych przemyślenia.

1. Skąd bierze się „ekonomia oburzenia”?

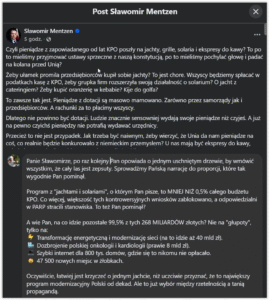

Badania pokazują, że główne platformy społecznościowe optymalizują swoje algorytmy pod kątem wskaźników zaangażowania – kliknięć, reakcji i udostępnień. Problem w tym, że emocje o wysokim ładunku – zwłaszcza gniew – generują więcej interakcji niż neutralne treści. Audyt Knight First Amendment Institute wykazał, że materiały wybrane przez algorytm Twittera zawierały gniew 62 % częściej niż losowa próbka postów. knightcolumbia.org

2. Facebook: pięć punktów za „wściekłość”, jeden za „lajk”

Wycieki ujawnione przez sygnalistkę Frances Haugen dowiodły, że Meta wiedziała o tym, iż reakcja 😡 ma większą wagę niż 👍, co zwiększało widoczność kontentu prowokującego oburzenie. cbsnews.com Dodatkowo internalne notatki Facebooka z 2017 r. wskazywały, że emoji „angry” były mnożone pięć razy, co przyczyniało się do rozpowszechniania treści skrajnych lub dezinformujących. washingtonpost.com

3. X/Twitter: algorytmiczna amplifikacja treści prawicowych

Rok 2021 przyniósł przeprosiny Twittera po tym, jak firma przyznała, że jej algorytm home feedu częściej promuje polityków konserwatywnych niż lewicowych. theguardian.com Nowsze badania (PNAS, 2022) potwierdziły, że algorytm promuje treści polaryzujące, ponieważ te generują najwyższy CTR. pnas.org

4. YouTube: „królicza nora” radykalizacji

Analiza UC Davis (2023) wykazała, że użytkownicy już po kilku kliknięciach otrzymywali rekomendacje filmów o charakterze ekstremistycznym. ucdavis.edu Systematyczny przegląd literatury (PMC, 2022) potwierdza tę tendencję w licznych badaniach audytowych. pubmed.ncbi.nlm.nih.gov

5. Pętla pozytywnego wzmocnienia oburzenia

Zespół Yale (Science Advances, 2021) wykazał, że „lajki” i „retweety” dla tweetów wyrażających moralne oburzenie zwiększają prawdopodobieństwo, iż autorzy będą publikować jeszcze bardziej gniewne treści w przyszłości – klasyczny mechanizm uczenia się przez nagrodę. science.org Axios podsumowało to słowami: „Algorytm podkręca głośność, bo gniew się klika”. axios.com

6. Konsekwencje społeczne

- Polaryzacja – wzrost wrogich ocen „out-grupy” i spadek zaufania społecznego.

- Przemoc offline – mowa nienawiści online koreluje z incydentami nienawiści w rzeczywistości.

- Zdrowie psychiczne – permanentny kontakt z agresją zwiększa stres i poczucie zagrożenia, zwłaszcza u młodzieży.

7. Co mogą zrobić regulatorzy?

- UE: Digital Services Act od 17 lutego 2024 r. nakłada na „VLOPy” obowiązek oceny ryzyka i audytu systemów rekomendacji, a od stycznia 2025 r. firmy podpisały rozszerzony Kodeks przeciwdziałania mowie nienawiści. commission.europa.eureuters.com

- USA: projekt Algorithmic Accountability Act 2023 wymaga od firm raportu z oceny wpływu każdego „systemu krytycznego”, w tym feedów społecznościowych. wyden.senate.gov

8. Co mogą zrobić platformy?

- Zmiana metryki – eksperyment Facebooka z usunięciem prognozowanych udostępnień z rankingu polityki obniżył toksyczność o ponad 50 %. knightcolumbia.org

- Friction & choice – opcjonalne feedy chronologiczne, limity udostępnień, wstawki „Czy na pewno chcesz to opublikować?”.

- Otwarte API dla audytorów – ułatwia niezależne badania.

9. Co możemy zrobić my?

- Świadomie zarządzać czasem – unikać doom-scrollingu, wyłączać push-notyfikacje.

- Zgłaszać i blokować – aktywnie korzystać z narzędzi moderacji.

- Wspierać dobre inicjatywy – subskrybować źródła jakościowe, wpłacać na organizacje fact-checkingowe.

Analiza faktów

- Ważenie reakcji emotikon – potwierdzone dokumentami Facebooka z 2017 r. i reportażem Washington Post; brak późniejszego dementi.

- Algorytmiczna stronniczość Twittera – przyznana publicznie przez firmę w 2021 r.; niezależne badania PNAS replikują wnioski.

- Skuteczność DSA – choć przepisy w pełni obowiązują od lutego 2024 r., nadal brak precedensowych kar; wymaga dalszego monitoringu.

- Wpływ internetu na przemoc – korelacja wysoka, lecz związek przyczynowy trudny do udowodnienia bez danych eksperymentalnych.

Źródła

https://www.wyden.senate.gov/imo/media/doc/algorithmic_accountability_act_of_2023_summary.pdf

https://www.washingtonpost.com/technology/2021/10/26/facebook-angry-emoji-algorithm/

https://www.pnas.org/doi/10.1073/pnas.2025334119

https://pubmed.ncbi.nlm.nih.gov/36466439/

Opublikuj komentarz